机器人开发能力

核心定位:通过云-边-端全栈技术栈,为无人机/机器人提供低延时、高鲁棒、自适应的视觉感知能力,使其在动态复杂环境中实现“感知-决策-执行”闭环。

三大赋能模式详解与适用边界

1. 离线服务器分析模式(After-Action Inspection)

工作流程:

机器人/无人机采集数据

存储至本地SD卡

人工取出存储介质

导入服务器视觉系统

AI 批量识别异常

人工复核并处理

核心特点:

零传输依赖

全程无网络需求,适用无信号区域(矿井、远洋、野外)

超低成本

仅需基础数据存储设备,无流量/算力租赁费用

适用场景

电网月度巡检、农业周期普查等非实时性任务,容忍24-72小时延迟

2. 4G/5G实时传输模式(Real-Time Cloud Analysis)

工作流程:

机器人/无人机实时拍摄

4G/5G高清回传

云端GPU服务器

AI实时识别异常

自动告警至监控中心

人工介入处置

核心特点:

秒级响应

端到端延时<1秒(需≥50Mbps稳定带宽)

高传输成本

1080P视频流月均流量费≈$300/设备(以AWS计费参考)

零传输依赖

城市安防巡逻、工地安全监控等发达地区高预算场景,需运营商网络全覆盖

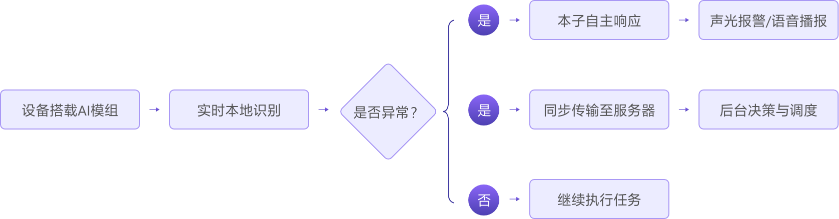

3. 端侧嵌入式智能模式(On-Device Autonomous)

工作流程与响应逻辑:

双路径响应详解:

本地自主响应(零网络依赖)

能力:设备直接触发预置动作(如播报警示语音、闪烁警报灯、紧急悬停)

场景:化工厂巡检机器人发现泄漏 → 本地播报“危险!请撤离!” → 人员现场响应

场景:化工厂巡检机器人发现泄漏 → 本地播报“危险!请撤离!” → 人员现场响应

云端协同响应(需网络支持)

能力:将关键信息(坐标、图像、置信度) 回传服务器,触发跨系统调度。

网络要求:需中低速稳定网络(≥2Mbps),传输数据量仅为原始视频的1/100(因仅传识别结果)。

场景:海上无人机识别求救信号 → 压缩传输坐标+快照至救援中心 → 调度直升机前往(依赖卫星网络)。

网络要求:需中低速稳定网络(≥2Mbps),传输数据量仅为原始视频的1/100(因仅传识别结果)。

场景:海上无人机识别求救信号 → 压缩传输坐标+快照至救援中心 → 调度直升机前往(依赖卫星网络)。

三大模式对比表:

| 评估维度 | 离线服务器分析模式 | 4G/5G实时传输模式 | 端侧嵌入式智能模式 |

| 网络需求 | ❌ 完全不依赖 | ✅ 需≥50Mbps高速网络 | ✅ 本地响应:离网 ✅ 云端联动:≥2Mbps |

| 端到端响应延时 | 数小时至数天 | <1秒 | 本地响应:<100ms 云端联动:<3秒* |

| 硬件改造成本 | ✅ 零新增硬件(需采购服务器软件授权) | ✅ 零新增硬件(需采购服务器软件授权) | ❗ 需加装AI模组 机器人:$120/台 无人机:$400+/台(含电池) |

| 传输/运营成本 | ❌ 无传输费用 | ❗ 高流量费($300+/月/设备) | ❗ 低传输费(仅报警数据) |

| 关键优势 | 零传输成本 | 全场景高清分析 | 本地响应:极速闭环 云端联动:跨系统调度 |

| 关键局限 | 无实时性 | 依赖网络覆盖 | 无人机续航↓25-30% |

| 典型场景 | 农业普查、电力存档巡检 | 城市实时监控(发达地区) | 本地响应:危险区域现场告警 云端联动:海上救援、跨部门协同 |

返回

返回